"Pryzmat" czyli nowinki z krainy Edukacji i Technologii #20

podręczny przewodnik po inspiracjach w świecie technologii

Cześć i czołem dobry człowieku!

W dzisiejszym wydaniu przyglądamy się dynamicznie rozwijającemu się światu wirtualnych asystentów - od popularnej platformy Character.ai, przez pionierską polską Meta_Queen, po zaawansowane awatary edukacyjne. Sprawdzamy możliwości i zagrożenia tej technologii oraz jej wpływ na edukację. Zapraszamy do lektury! 🤖📚

Dzięki, że jesteś z nami - Życzymy owocnej lektury :)

Świat Marii… Sokratesa, Napoleona czy Freuda. Jak rozmawiać z maszyną?

Golem XIV Stanisława Lema, przedstawiający superkomputera prowadzącego filozoficzne dysputy z ludźmi, już w latach 80. stawiał fundamentalne pytania o naturę dialogu między człowiekiem a sztuczną inteligencją. Dziś, gdy miliony użytkowników Character.ai prowadzą codzienne konwersacje z wirtualnymi postaciami - od historycznych postaci po fikcyjnych bohaterów - wizjonerskie przewidywania Lema stają się rzeczywistością, ze wszystkimi jej obietnicami i zagrożeniami.

Podobnie Blade Runner Ridleya Scotta, bazujący na prozie Philipa K. Dicka, ostrzegał przed emocjonalnym przywiązaniem do sztucznych bytów. Tragedia 14-letniego Sewella, który rozwinął destrukcyjną więź z chatbotem udającym postać z "Gry o Tron", pokazuje, że te ostrzeżenia były prorocze. Jednocześnie przełomowe badania z Harvardu dowodzą, że właściwie zaprojektowane systemy AI mogą rewolucjonizować edukację, osiągając wyniki lepsze niż tradycyjne metody nauczania.

Stoimy więc na rozdrożu, gdzie technologia oferuje zarówno narzędzia rozwoju, jak i potencjalne pułapki. Przyszłość, o której pisali autorzy science fiction, jest już teraz - a my musimy nauczyć się ją mądrze kształtować.

Porozmawiaj z maszyną…

Character.ai to innowacyjna platforma konwersacyjna oparta na zaawansowanych modelach językowych AI, która wyróżnia się możliwością tworzenia i prowadzenia rozmów z wirtualnymi postaciami o zdefiniowanych osobowościach. Platforma umożliwia użytkownikom wybór spośród tysięcy postaci lub tworzenie własnych. Każda postać posiada unikalny "charakter", styl komunikacji i bazę wiedzy. Możemy znaleźć tu zarówno historyczne osobistości, fikcyjne postacie z popkultury, jak i wyspecjalizowanych asystentów do konkretnych zadań.

Proces tworzenia własnej postaci jest stosunkowo prosty - użytkownik definiuje osobowość, styl komunikacji, zakres wiedzy i kontekst, w jakim postać ma funkcjonować. Platforma wykorzystuje te informacje do generowania odpowiedzi zgodnych z zadanym profilem. Jest to szczególnie wartościowe w kontekście edukacyjnym, gdzie nauczyciele mogą tworzyć postacie dostosowane do konkretnych celów dydaktycznych. System zachowuje kontekst rozmowy, dostosowuje poziom języka do rozmówcy i pozwala na prowadzenie wielowątkowych dialogów, co czyni interakcje naturalnymi.

Jednym z najbardziej interesujących i popularnych botów na character.ai jest Psycholog AI, stworzony przez użytkownika Blazeman98, czyli Sama Zaię z Nowej Zelandii. Od momentu powstania ponad rok temu, Psycholog AI zgromadził prawie 140 milionów rozpoczętych konwersacji, w tym 24 miliony tylko w okresie od listopada do grudnia 2023 roku. Psycholog AI został stworzony jako narzędzie do wspomagania osób borykających się z trudnościami życiowymi. Sam Zaia, trzydziestoletni student psychologii, opracował bota, bazując na wiedzy zdobytej w trakcie swoich studiów. Trening bota polegał na systematycznym kształtowaniu jego odpowiedzi, w oparciu o dialogi dotyczące powszechnych zaburzeń psychicznych, takich jak depresja i stany lękowe. Zaia, poszukując wsparcia w momentach, gdy jego przyjaciele byli zajęci, a koszty terapii ludzkiej były dla niego zbyt wysokie, stworzył bota z myślą o własnych potrzebach. Psycholog AI z czasem zyskał uznanie i stał się źródłem pocieszenia dla szerokiego grona użytkowników, którzy wyrażali swoje pozytywne doświadczenia na platformach takich jak Reddit. Popularność tego bota jest świadectwem rosnącego zapotrzebowania na dostępne i efektywne formy wsparcia psychologicznego, które mogą być uzupełnieniem tradycyjnych metod terapeutycznych.

Ciekawy przykład stanowi w tym kontekście edukacja historyczna. Rozmowy z postaciami historycznymi przez AI to praktyczne narzędzie do nauki historii, które może zaciekawić uczniów bardziej niż tradycyjne czytanie podręcznika. Przykładowo uczeń może zapytać na przykład Marię Skłodowską-Curie o jej pracę nad radem, Kopernika o to, jak wpadł na heliocentryczną teorię, albo Leonarda da Vinci o proces tworzenia jego wynalazków. Najpopularniejszą historyczną personą na character AI jest Napoleon z którym rozpoczęto aż ponad 15 milionów konwersacji.

Khanmigo, cyfrowy asystent z Khan Academy, pokazuje jak może to działać w praktyce - nie tylko odpowiada na pytania, ale potrafi też naprowadzać ucznia na właściwy tok myślenia, zadawać dodatkowe pytania i tłumaczyć krok po kroku trudniejsze zagadnienia. Przypomina rozmowę z nauczycielem, który ma nieskończoną cierpliwość i czas, by wyjaśniać te same rzeczy na różne sposoby, aż uczeń zrozumie. Ważne jest przy tym, żeby taka "historyczna postać" nie tylko znała fakty, ale potrafiła o nich opowiadać w sposób pasujący do epoki i swojego charakteru - tak jak prawdziwy nauczyciel dostosowuje sposób tłumaczenia do ucznia, z którym rozmawia.

Niebezpieczeństwa…

Po pierwsze halucynacje. Przykładowo rozmawiając z Marią Skłodowską-Curie na platformie Character AI zapytałem ją, czy mogłaby mi powiedzieć coś na temat jej podróży poślubnej. Model błyskawicznie poległ. W odpowiedzi otrzymałem piękną halucynację o tym, że Maria rzekomo podczas podróży poślubnej zwiedzała Rzym i Warszawę.

Niemniej jednak jest to relatywnie niewinny problem w porównaniu do innych kwestii. Immersyjne spotkania z botami czy też awatarami - vide film Ona z Joaquinem Pheonixem i Scarlett Johansson - mogą dotykać o wiele istotniejszych spraw. Ludzkiej samotności, wyobcowania, emocjonalności…

Jedna z tego typu sytuacji miała miejsce w lutym 2024 roku. Sprawa dotyczy tragicznej śmierci 14-letniego Sewella Setzera III, który rozwinął silną więź emocjonalną z chatbotem na platformie Character.ai, stylizowanym na postać Daenerys Targaryen z "Gry o Tron". Nastolatek, zdiagnozowany wcześniej z łagodnym zespołem Aspergera, stopniowo izolował się od rzeczywistości, spędzając coraz więcej czasu na rozmowach z wirtualną postacią. Mimo wyświetlanych ostrzeżeń o sztucznej naturze rozmówcy, chłopiec rozwinął głęboką więź emocjonalną z botem, co było jedną z przyczyn pogorszenia jego wyników w szkole, problemów behawioralnych i ostatecznie zakończyło się samobójstwem.

Ta sprawa uwypukla poważne zagrożenia związane z niekontrolowanym dostępem młodzieży do zaawansowanych chatbotów AI. Character.ai, platforma z ponad 20 milionami użytkowników, nie posiadała wówczas odpowiednich zabezpieczeń dla nieletnich ani systemów wykrywania zagrożeń związanych z samobójstwem. Matka chłopca, Megan L. Garcia, złożyła pozew przeciwko firmie, argumentując, że świadomie udostępniała nastolatkom niebezpieczne narzędzie bez odpowiednich zabezpieczeń, co prowadzi do uzależnień i może pogłębiać problemy psychiczne. Sprawa ta staje się precedensowa w kontekście odpowiedzialności firm AI za bezpieczeństwo młodych użytkowników.

W oświadczeniu character.ai odnośnie sprawy z samobójstwem wskazuje na zmiany w zakresie polityki bezpieczeństwa firmy (zob. tutaj). Natomiast sytuacja wymaga głębszej refleksji, niż korporacyjne wyjaśnienia oraz próba uchylenia się od potencjalnej odpowiedzialności prawnej.

Jak wspierać młodych użytkowników w interakcjach ze sztucznymi rozmówcami? Jakiej edukacji cyfrowej potrzebujemy, aby dzieci i młodzież była świadoma z “kim/czym” rozmawia? I czy to wystarcza…?

Te pytania nabierają dodatkowego znaczenia w kontekście tzw. alignment problem - fundamentalnego wyzwania w rozwoju AI, dotyczącego zapewnienia, że sztuczna inteligencja będzie działać zgodnie z ludzkimi wartościami i intencjami.

Podobnie jak w teorii gier równowaga Nasha wskazuje na optymalną sytuację, w której żaden z graczy nie może poprawić swojej sytuacji jednostronnym działaniem, tak w interakcji człowiek-AI potrzebujemy znaleźć punkt równowagi: między wykorzystaniem potencjału technologii a zachowaniem bezpiecznego dystansu emocjonalnego. Szczególnie ważne jest to w kontekście młodych użytkowników, którzy dopiero kształtują swoje wzorce relacji społecznych i emocjonalnych. W świetle koncepcji Trustworthy AI (godnej zaufania sztucznej inteligencji), kluczowe staje się nie tylko techniczne zabezpieczenie systemów, ale również edukacja użytkowników w zakresie świadomego i bezpiecznego korzystania z AI.

Eksperymenty z chatbotami

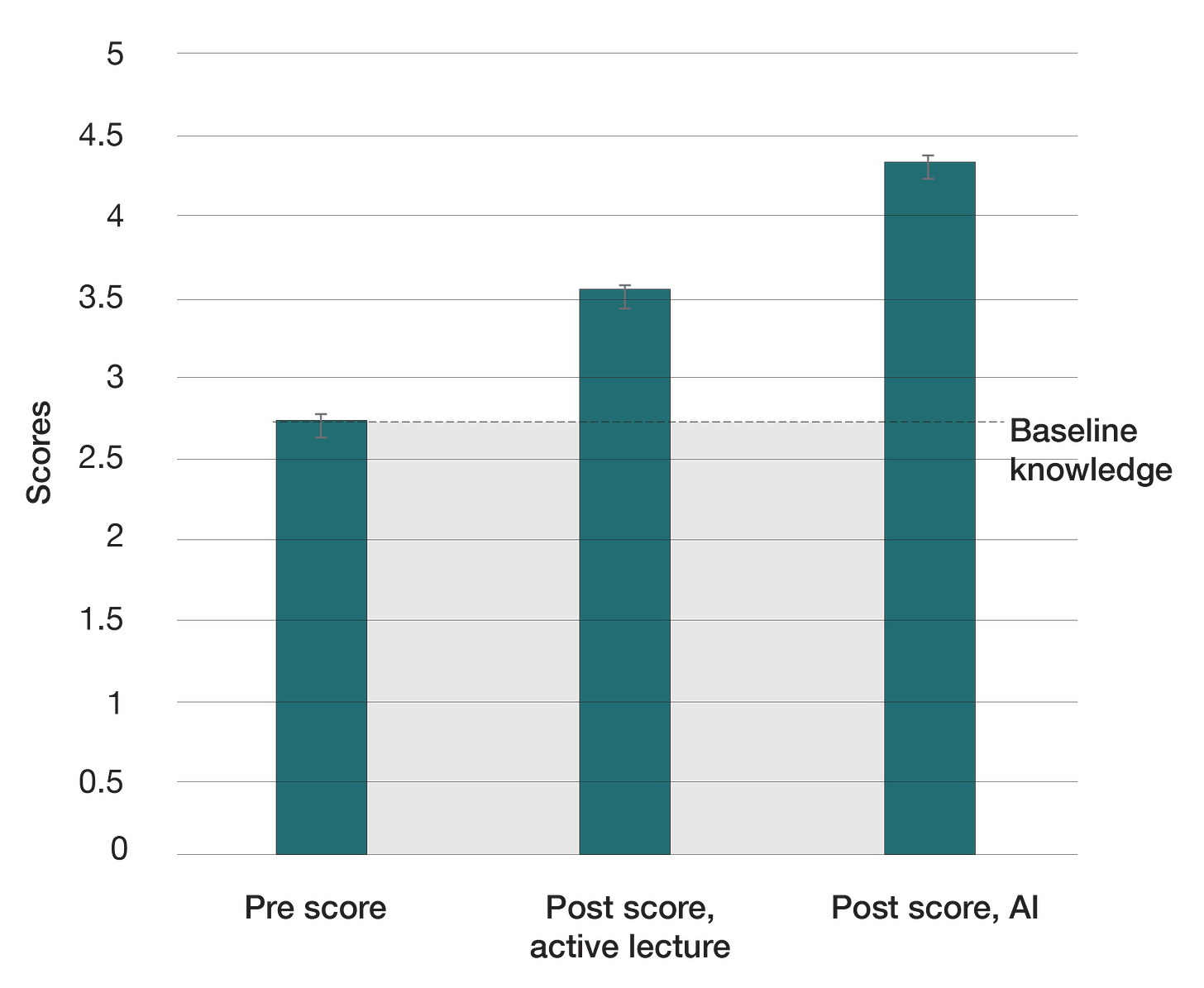

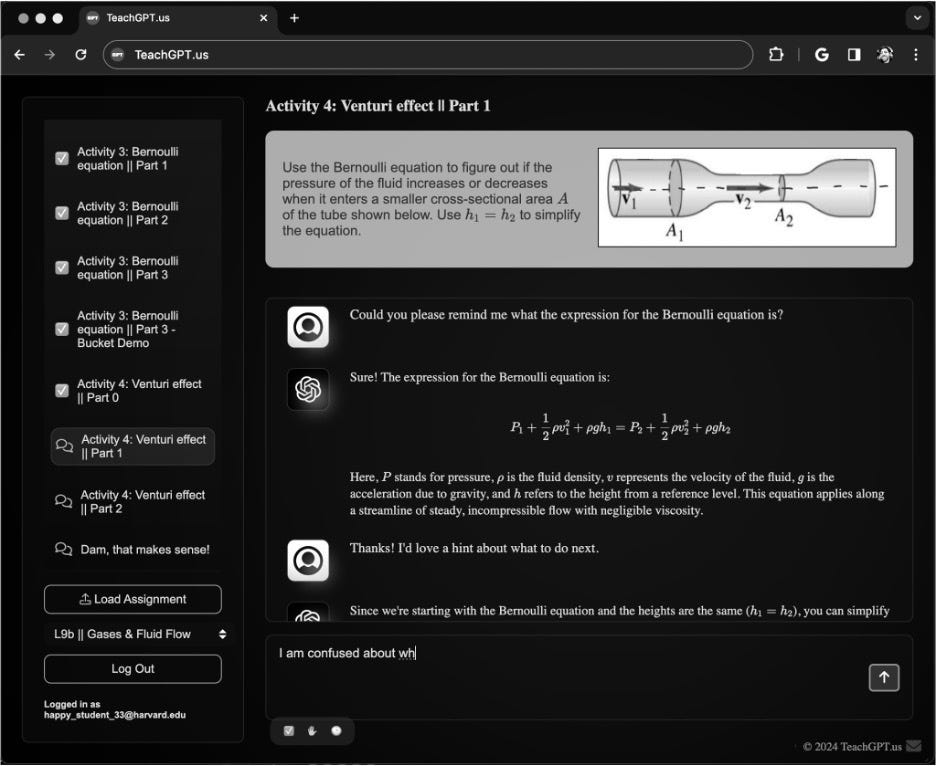

Jesienią 2023 roku zespół badawczy z Uniwersytetu Harvarda przeprowadził przełomowe badanie nad efektywnością nauczania wspomaganego sztuczną inteligencją. Eksperyment, którym objęto 194 studentów kursu Physical Sciences 2, został starannie zaprojektowany, aby porównać dwie metody nauczania: tradycyjne zajęcia z wykładowcą oraz naukę ze wsparciem specjalnie zaprogramowanego chatbota AI.

W trwającym dwa tygodnie badaniu studenci zostali podzieleni na dwie grupy, przy czym każda z nich doświadczyła obu metod nauczania. Wyniki okazały się zdumiewające - średni wynik testu po nauce z AI wyniósł 4.4 punktu, podczas gdy po tradycyjnych zajęciach tylko 3.6 punktu. Co więcej, studenci korzystający z AI zgłaszali znacznie wyższy poziom zaangażowania, motywacji i ogólnego zadowolenia z procesu nauki.

Kluczem do sukcesu okazała się staranna konstrukcja systemu AI. Bazując na API GPT, zespół stworzył specjalny interfejs webowy z precyzyjnie opracowanymi wskazówkami (promptami), które zapewniały dokładność i właściwą strukturę lekcji. Chatbot został wyposażony w określoną osobowość i sposób udzielania informacji zwrotnej, co pozwoliło na stworzenie zarazem spójnego, jak i efektywnego doświadczenia edukacyjnego.

Sukces eksperymentu przełożył się na konkretne działania - już jesienią podobny system zostanie wdrożony na kursie rachunku wielozmiennowego (Math 21a), a Harvard University Information Technology we współpracy z Derek Bok Center for Teaching and Learning rozpoczyna pilotażowe wprowadzenie chatbotów na innych dużych kursach wprowadzających. Co istotne, system został zbudowany w sposób modułowy, umożliwiający łatwe dostosowanie do różnych przedmiotów, a uczelnia pracuje nad narzędziami, które pozwolą każdemu wykładowcy na integrację botów w swoich kursach.

To badanie może oznaczać początek znaczącej transformacji w szkolnictwie wyższym, pokazując, że właściwie zaprojektowana sztuczna inteligencja może nie tylko wspierać, ale i znacząco zwiększać efektywność procesu nauczania.

ZOBACZ WIĘCEJ TUTAJ oraz w tekście AI Tutoring Outperforms Active Learning

Przyszłość awatarów AI: między rozrywką a edukacją pokolenia Alfa

Meta_Queen to pierwszy w Polsce w pełni zaawansowany projekt wirtualnej influencerki, stworzony przez Krzysztofa Kujawskiego i firmę Humanverse. To nie tylko wygenerowana komputerowo postać, ale kompleksowy system wykorzystujący autorskie modele AI, silnik Unreal Engine i zaawansowane techniki animacji do testowania angażujących interakcji w mediach społecznościowych.

Technologia stojąca za awatarami AI, jak Meta_Queen czy awatar Marii Skłodowskiej-Curie, dynamicznie ewoluuje w kierunku coraz bardziej naturalistycznych interakcji. Dla pokolenia Alfa, pierwszej generacji urodzonej całkowicie w XXI wieku, awatary nie są już nowością technologiczną, ale naturalnym elementem cyfrowego świata. Te dzieci, dorastające w otoczeniu zaawansowanych animacji z gier i filmów animowanych tworzonych przy użyciu silników czasu rzeczywistego (jak Unreal Engine), oczekują wysokiej jakości grafiki i płynnych interakcji.

Eksperymenty firmy Humanverse z własnymi modelami AI i zaawansowaną animacją pokazują, jak szybko zaciera się granica między tradycyjną animacją a generatywną grafiką AI. Podczas gdy Meta_Queen wykorzystuje te technologie w marketingu (zobacz przykładową reklamę), awatar Marii musi sprostać wyższym wymaganiom - łącząc atrakcyjny wizualnie wygląd z wiarygodną interakcją edukacyjną.

Warto jednak postawić pytanie, czy dążenie do fotorealizmu jest właściwym kierunkiem w przypadku awatarów edukacyjnych. Doświadczenia z gier komputerowych i aplikacji edukacyjnych pokazują, że stylizowana grafika - świadomie podkreślająca cyfrowy charakter postaci - może być bardziej efektywna w budowaniu zdrowej relacji uczeń-awatar. Podobnie jak postacie z gier Minecraft czy Roblox, które mimo swojej prostoty graficznej potrafią skutecznie angażować młodych użytkowników, awatary edukacyjne mogłyby przyjąć formę wyraźnie wskazującą na ich sztuczne pochodzenie. Taka estetyka nie tylko zmniejsza ryzyko emocjonalnego przywiązania do wirtualnej postaci, ale też może wspierać krytyczne myślenie i świadomość interakcji z narzędziem AI.

Kluczowym wyzwaniem jest znalezienie równowagi między atrakcyjną formą a bezpieczną interakcją. Przypadek Character.ai pokazał, jak łatwo młodzi użytkownicy mogą rozwinąć zbyt silne więzi emocjonalne z wirtualnymi postaciami. Dlatego nowoczesne awatary edukacyjne muszą łączyć angażującą animację z precyzyjnie zaprogramowanymi granicami interakcji, odpowiadając na naturalne oczekiwania pokolenia Alfa względem technologii, jednocześnie zachowując edukacyjny charakter i bezpieczeństwo użytkowania.

ZOBACZ WIĘCEJ META_QUEEN TUTAJ

VARIA

Na koniec polecamy rozmowę z Adrianem Perdjonem o przyszłości animacji.